Un algorithme français pour prédire la qualité littéraire d'un livre

On ne confiera pas demain la gestion d'une ligne éditoriale ni d'une collection à un robot, mais Short Édition travaille actuellement à un outil mêlant Data mining et Big Data. Le tout pour arriver à l'élaboration d'un algorithme, susceptible de définir la qualité d'un texte. S'appuyant sur la technologie du Machine Learning, la solution aidera, dans un premier temps, la maison d'édition à mieux sélectionner ses textes.

Le 21/07/2014 à 10:01 par Nicolas Gary

Publié le :

21/07/2014 à 10:01

brianjmatis, CC BY SA 2.0

Quentin Pleplé, cofondateur et responsable technique de la maison insiste rigoureusement : « Il ne s'agit pas de remplacer notre Comité éditorial par une machine : plutôt que cette dernière serve de filtrage-assistant, dans une détection, moins de la qualité littéraire, que de l'absence de qualités. » En somme, l'ordinateur va pointer, dans les textes qu'on lui fera découvrir, des séries de critères, qui seront alors confirmés par un cerveau humain, « là où, aujourd'hui, nous faisons lire les livres reçus par cinq à dix personnes ». Un gain de temps, pour chacun.

Cet « algorithme de prédiction de la qualité littéraire » est donc avant tout un outil destiné à l'usage strict de la maison. « Nous nous appuyons sur une base de données des oeuvres proposées par Short, et qui ont été évaluées par cinq à dix lecteurs. À partir de ces premières datas, nous commençons à faire apprendre la machine : l'intelligence artificielle va traiter les données et établir des liens entre la qualité et les exigences. »

Mais un algorithme ne sert que très peu, s'il ne lui est pas donné de se perfectionner. Il effectuera dans un premier temps ses passages en revue, selon différents critères, et les concepteurs évalueront alors ses résultats. « Nous ne pourrons nous en servir qu'à compter du moment où la marge d'erreur sera considérée comme acceptable, et suffisante pour être fiable. Même à cet instant, nous ne nous passerons pas d'une lecture humaine. »

Sémantique, syntaxe, champs lexicaux ; passer au crible

Une première base de 25.000 oeuvres sert donc à remplir l'esprit de l'intelligence artificielle, afin de lui fournir les bases d'une première série d'évaluation. Avec le temps, l'outil disposera de nouvelles références, de nouveaux critères, et apportera « un regard de plus en plus correct sur la probabilité d'une qualité littéraire, pour les textes qui nous seront présentés ». Aux côtés de la maison d'édition, plusieurs partenaires, pour certains Grenoblois, dont ProbaYes*, qui opère comme développeur exécutant, « C'est par eux que débutera la phase d'industrialisation de cet outil », nous précise Quentin Pleplé.

L'objectif initial est donc d'opérer une sélection en amont, tout en restant prudent sur les critères de l'ordinateur. Parmi les différents éléments qu'il mesurera, on retrouve :

• indicateurs sémantiques - le nombre de répétitions d'un mot, ou de plusieurs, à l'intérieur du texte ; cela impliquera également de faire apprendre à la machine des figures de style, comme l'anaphore, pour mieux orienter ses conclusions

• l'ampleur du champ lexical : « Le recours à des termes argotiques, vulgaires ou des mots rares pourra apporter des indications sur la qualité globale, et proposer un tamis pour anticiper certains textes », précise Quentin Peplé.

• la longueur des phrases, des paragraphes (vers et strophes y compris), allant jusqu'à des mesures syntaxiques, comme le nombre de propositions relatives, seront autant d'indicateurs

• le style, dans son ensemble, passera par une classification grammaticale des termes employés (quantité d'adverbes, d'adjectifs, de pronoms, de verbes, de noms, etc.)

• « Les fautes d'orthographe et de ponctuation sont également de puissants indicateurs, particulièrement efficaces quand il s'agit d'évaluer qualitativement un texte », insiste le cofondateur.

• enfin, la machine recherchera la lisibilité du texte, prenant comme référence les ouvrages jeunesse, comme particulièrement simple à appréhender, et des documents traitant d'économie, plus rébarbatifs, et complexes. Entre les deux, tout un champ d'évaluations possibles, qui se coupleront à un examen reposant sur la cohésion du texte. « L'enchaînement sémantique et primordial, pour une lecture agréable : les connecteurs logiques et plus largement la suite des idées du texte, seront mesurés. »

Il ne manqerait plus que l'évaluation de la couverture. On se demande par avance ce qu'il adviendra de Céline ou de Proust, passés par une pareille moulinette.

HAL, nouvel assistant éditoriHAL ?

Si c'est avec la base de données de Short Édition que l'on va entraîner la machine, c'est que son catalogue regroupe des oeuvres aux profils très distincts les uns des autres, et « dont la qualité littéraire est évaluée rigoureusement par un nombre important de lecteurs experts profilés ». Tous les travaux de recherche actuellement en cours sur le croisement entre sémantique et Data mining serviront, demain, à la création de cet assistant éditorial, comme un précieux soutien pour un comité chargé de lire tout ce qui est reçu.

ActuaLitté, CC BY SA 2.0

« Nous pourrons mesurer plein de choses, introduire de nouveaux critères et procéder à des évaluations progressives, jusqu'à obtenir une solution concluante, qualitativement. Le ‘Machine Learning' repose autant sur la capacité d'apprentissage de l'outil informatique, que sur la finesse des critères qu'on lui impose. Nous devons former son analyse, vierge de tout critère, pour lui apporter un contenu, qui le fera progresser. »

Et de prendre l'exemple, tiré de Marcel Pagnol, d'une lettre écrite dans un français d'enfant, bourrée de fautes. « L'ordinateur ne saura pas distinguer l'effet de style, au départ, alors il signalera un passage particulièrement mal écrit, sur l'ensemble du livre. Mais avec le temps, la machine saura reconnaître qu'il y a un changement spécifique, et pourquoi pas, l'analyser correctement. »

Un apport pour la presse, l'édition, les bibliothèques

Concrètement, Short Edition sera le premier à profiter de toute cette technologie, utilisée une fois encore comme une aide à la prise de décision, et certainement pas comme substitut à une lecture humaine. Cependant, cette innovation aura aussi un grand intérêt pour les acteurs de l'édition (préévaluation des manuscrits) et pour les acteurs de la presse (médias ou contenus participatifs, nouveau modèle économique avec le digital) qui vont être confrontés à la problématique de gestion d'un très important flux entrant de textes et de leur traitement.

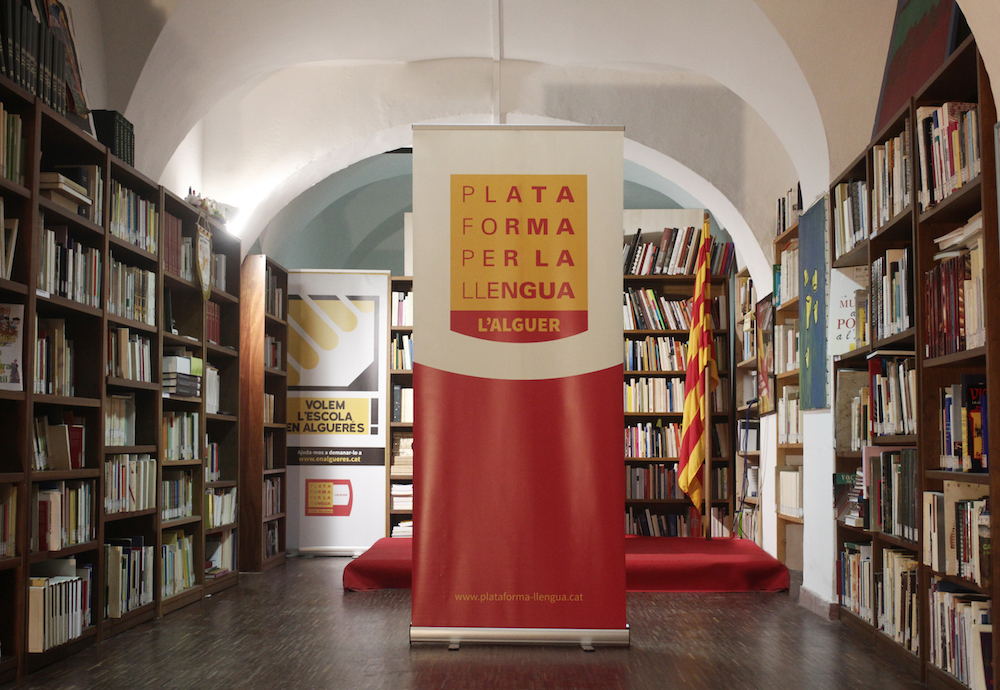

« Ouvrir notre technologie à d'autres acteurs fait partie de notre modèle économique. Nous proposerons de faire mouliner la technologie de Machine Learning, pour anticiper certaines lectures de textes. Elle pourra par exemple servir pour les bibliothèques, dans la classification d'ouvrages numérisés, mais également pour la presse. Dans l'édition, elle pourra apporter un premier éclairage sur les ouvrages reçus », garantit Quentin Peplé.

L'idée que la machine puisse effectuer un tri est séduisante, mais comme toujours, on redoute qu'elle ne finisse par lisser la sélection, et uniformiser d'une certaine manière les choix éditoriaux. « Elle ne sera jamais celle qui décide : elle n'aura pour vocation que de filtrer, selon certains critères. » Ainsi, non seulement la Machine pourrait évaluer, moins l'absence de qualité littéraire, finalement, que sa présence, mais détecter des textes susceptibles de faire polémique, ou consensus. « Elle sera en mesure de classer, selon des critères, une fois encore découlant des modes de notation du Comité éditorial, dans des genres littéraires, ou de mesurer le degré d'émotion qui se dégage - en mesurant les indicateurs liés à la joie, la peur, le plaisir, etc. »

Et Quentin Peplé de conclure : « Si la Machine, après analyse, finit par fournir une note, pour évaluer l'oeuvre proposée, c'est finalement moins la note qui est intéressante, que sa capacité à justifier la note. Cette démonstration-là sera vraiment passionnante. »

* Le programme de recherche de Short Édition est réalisé en collaboration avec trois laboratoires spécialisés en intelligence artificielle : le LIMSI adossé à l'Université Paris Sud (Orsay), le LIRIS adossé à l'Université Lyon I et le LIG adossé à l'INRIA et au CNRS.

Ce programme ambitieux est soutenu par BPI France (ex OSEO) à partir de 2014. La start-up est par ailleurs accompagnée par ProbaYes, société spécialisée en apprentissage automatique et en analyse prédictive, basée à Grenoble.

Commenter cet article