Apache Spark. Développez en Python pour le big data

Extraits

Informatique

Apache Spark. Développez en Python pour le big data

01/2022

Programmation

Apache Spark et Python. Coffret en 2 volumes : Maîtrisez le développement pour le Big Data

02/2024

Programmation

Python pour la data science

04/2022

Sports

Big Data Foot. Comment les datas révolutionnent le football ?

09/2019

Informatique

Python pour la data science pour les nuls

11/2019

Informatique

Big Data & Streaming. Le traitement streaming & temps réel des données en Big Data

07/2019

Sociologie

Ainsi parlait le Big data

10/2018

Informatique

Apache NetBeans. Développez vos applications en Java

01/2021

Informatique

Python pour la carte micro:bit

09/2019

Informatique

PyQt5. Développez vos interfaces graphiques en Python

01/2021

Actualité médiatique internati

Petit dico critique du Big Data

05/2023

Informatique

Big Data, Machine Learning et apprentissage profond

04/2019

Informatique

L’économie de partage et le Big Data analytics

07/2019

Programmation

Data Science avec Python. Avec Jupyter et PyCharm

03/2022

Informatique

Big Data et Machine Learning. Les concepts et les outils de la data science, 3e édition

08/2019

Economie (essai)

Big Data et plateformes. La nouvelle économie des données

10/2022

Gestion

La boîte à outils de la stratégie Big Data

09/2018

Informatique

Hadoop. Devenez opérationnel dans le monde du Big Data

04/2017

Gestion

(Ré)inventez votre business model par le Big Data

04/2018

Programmation

Python pour le data scientist. Des bases du langage au machine learning, 2e édition

03/2021

Programmation

Python pour le data scientist. Des bases du langage au machine learning, 3e édition

03/2024

Littérature française

Requiem pour une apache

CNLMusique – Jolene n'est pas la plus belle, pas la plus fine non plus. Et pas forcément la plus sympa. Mais lorsqu'elle arrive dans cet hôtel, elle est bien accueillie. Un hôtel ? Plutôt une pension qui aurait ouvert ses portes aux rebuts de la société : un couple d'anciens taulards qui n'a de cesse de ruminer ses exploits, un ancien catcheur qui n'a plus toute sa tête, une jeune homme simplet, une VRP qui pense que les encyclopédies sauveront le monde et un chanteur qui a glissé sur la voie savonneuse de la ringardisation. Ce petit monde vivait des jours tranquilles jusqu'à ce que Jolene arrive. En quelques mois à peine, l'hôtel devient le centre de l'attention et le quartier général d'une révolte poétique, à l'issue incertaine.

08/2020

Littérature française

Requiem pour une apache

01/2022

Marketing

Big Quali. La puissance des études qualitatives à l'ère du Big Data

01/2022

Programmation

Python pour la Data Science. Analysez vos données avec NumPy, Pandas, Matplotlib et Seaborn

03/2023

Informatique

La donnée n'est pas donnée. Stratégie & Big Data

06/2016

Histoire et Philosophiesophie

La recherche scientifique à l'ère des Big Data. Cinq façons dont les Big Data nuisent à la science et comment la sauver

04/2019

Sciences politiques

Big data électoral. Dis-moi qui tu es, je te dirai pour qui voter

04/2019

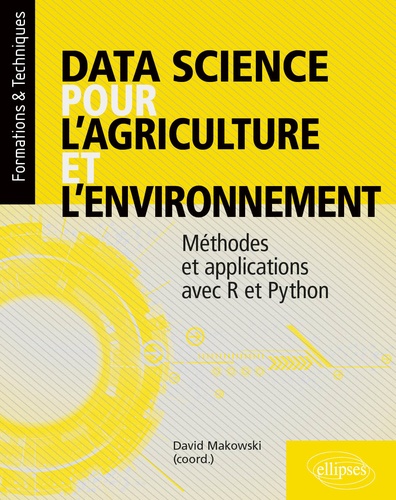

Agriculture

Data science pour l’agriculture et l’environnement. Méthodes et applications avec R et Python

03/2021

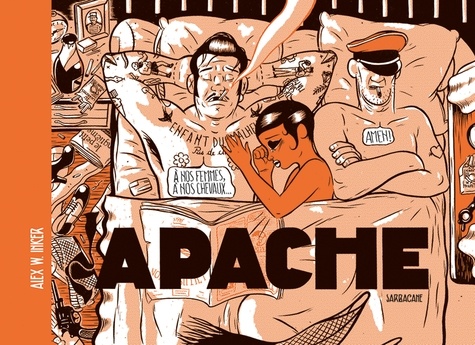

BD tout public

Apache

03/2016