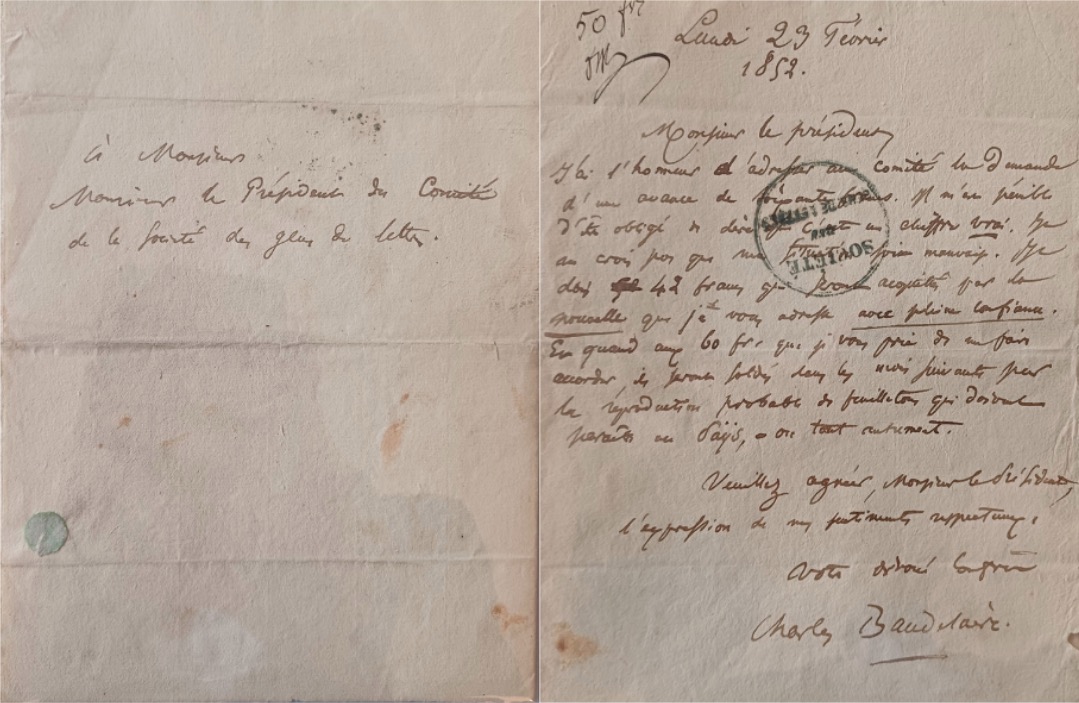

Oeuvres indisponibles : Quelle qualité de numérisation dans ReLIRE ?

Dans le cadre de la loi qui vise à permettre la numérisation des oeuvres indisponibles du XXe siècle, toujours sous droit, l'un des aspects importants, et finalement assez peu évoqué, reste le pan technique de ladite numérisation. Passer des ouvrages par les scanners pour leur redonner une vie numérique, voilà qui est touchant, mais nécessite tout de même de fixer les seuils nécessaires dans la qualité de transformation des livres papiers en versions numériques homothétiques. Et sur ce point, on s'en doute, il y a quelques couacs.

Le 06/02/2014 à 14:40 par Nicolas Gary

Publié le :

06/02/2014 à 14:40

La Sofia avait organisé la semaine passée une table ronde pour sensibiliser les auteurs à l'ensemble du projet ReLIRE, ou Registre des Livres Indisponibles en Réédition électronique. À force d'articles sur le sujet, il semble qu'Actualité ait cependant plus travaillé à sa publicité que l'ensemble des opérateurs concernés, nous expliquait-on. Soit, eh bien, poursuivons cette mission d'intérêt public.

Petite piqûre de rappel : la numérisation pour les nuls

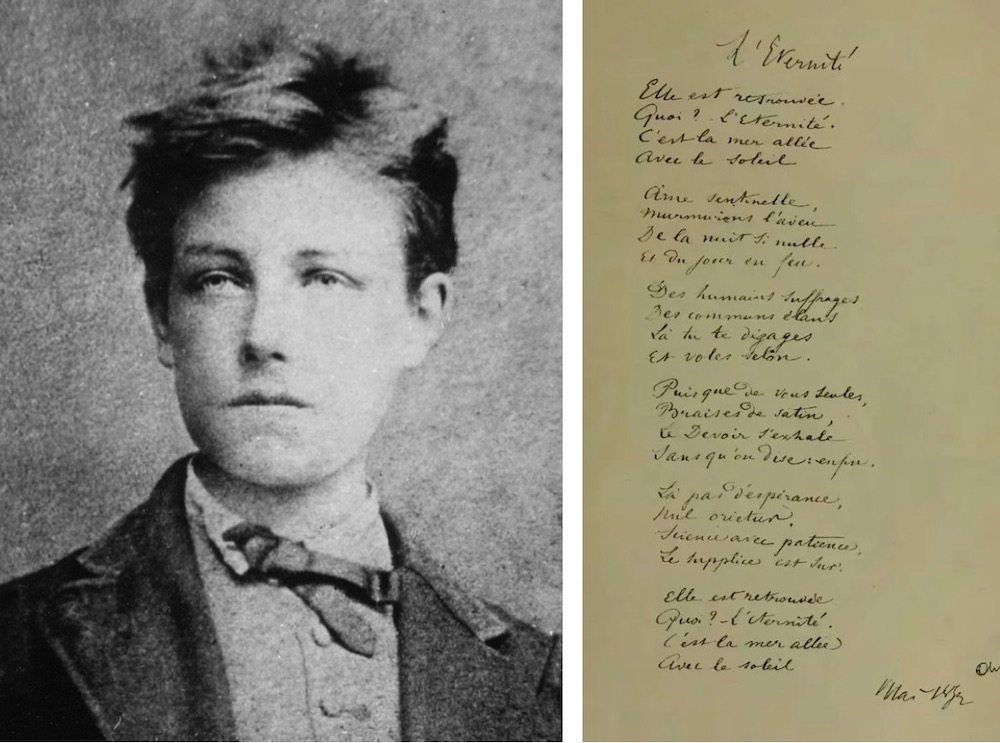

Dans un premier temps, Régis Habert, chargé des oeuvres indisponibles pour le compte du Cercle de la Librairie avait fait état de deux données, portant sur la qualité des fichiers. Pour les comprendre

il faut décortiquer un chouia le procédé.

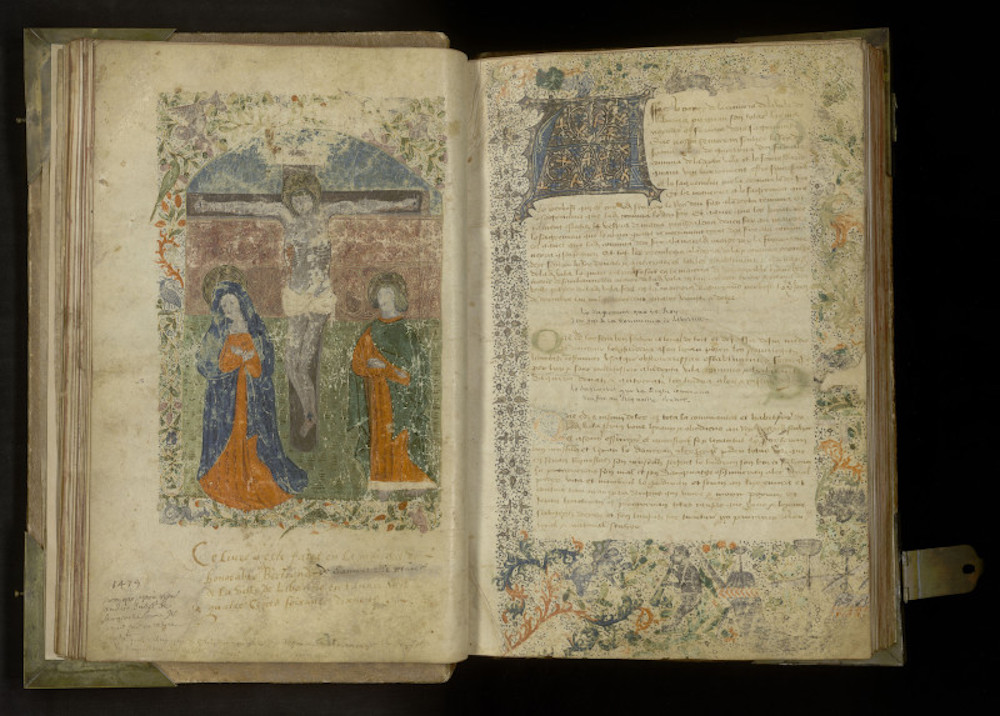

Tout livre papier est tout d'abord scanné, pour aboutir à un fichier image - des photographies des pages. À partir de ce document, deux approches :

la première, pour réaliser un PDF avec couche de texte caché, le procédé mis en place par Google Books, et inventé originellement par Adobe, et qui permet de faire de la recherche plein texte

la seconde, pour réaliser un fichier EPUB, format ouvert pour le livre numérique

Dans les deux cas, on a recours à l'OCR, ou Optical Character Recognition, la Reconnaissance optique de caractères. Ce processus est bien entendu automatisé, un logiciel de reconnaissance est alors utilisé, mais il nécessite l'intervention d'un être humain, malgré tout, pour assurer une relecture qui supprimera les erreurs commises par la machine.

Comme l'avait donc expliqué Régis Habert, la Société de projet en charge de ReLIRE s'occupera de numériser les livres dont elle obtiendra les droits d'exploitation. Or, ce dernier avait, au cours de cette table ronde, avancé des chiffres pharaoniques : 99,999 % de qualité éditoriale pour la création de fichiers EPUB et 99,50 % pour la couche de texte cachée des PDF. Intrigué par de tels chiffres, pour le moins inédits, ActuaLitté avait contacté la Sofia qui nous confirmé qu'il y avait une confusion dans les chiffres.

La perfection n'est pas de ce monde, surtout en OCR

Après vérification, voici la réponse définitive de l'organisme :

Cette numérisation sera réalisée, comme cela était indiqué dans la présentation du 30 janvier dernier, dans le respect total des normes de qualité qui seront publiées par la SOFIA dans ses licences d'exploitation, exclusives ou non exclusives.

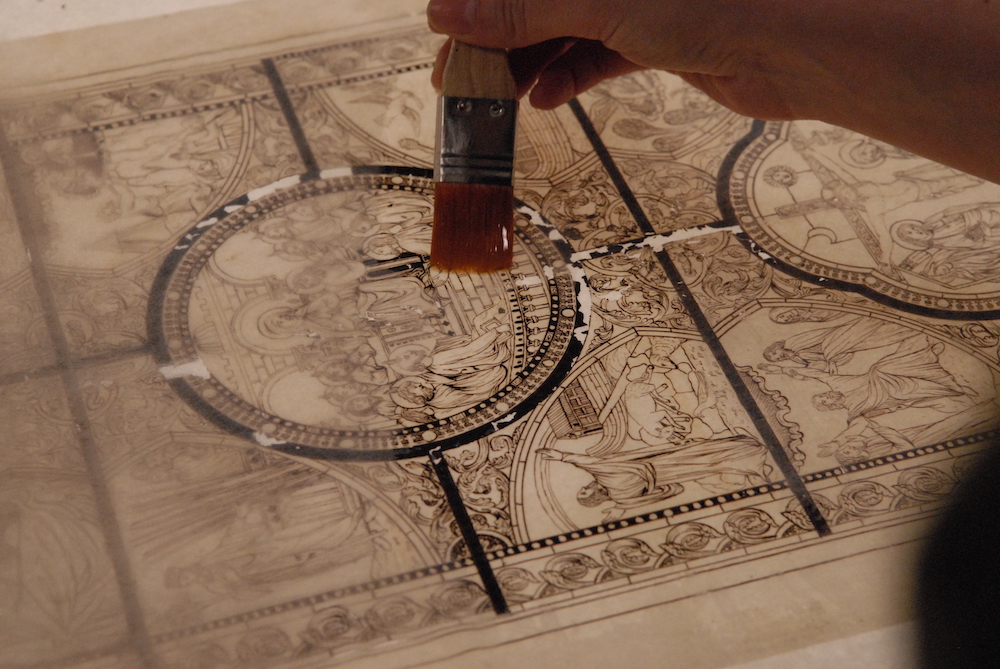

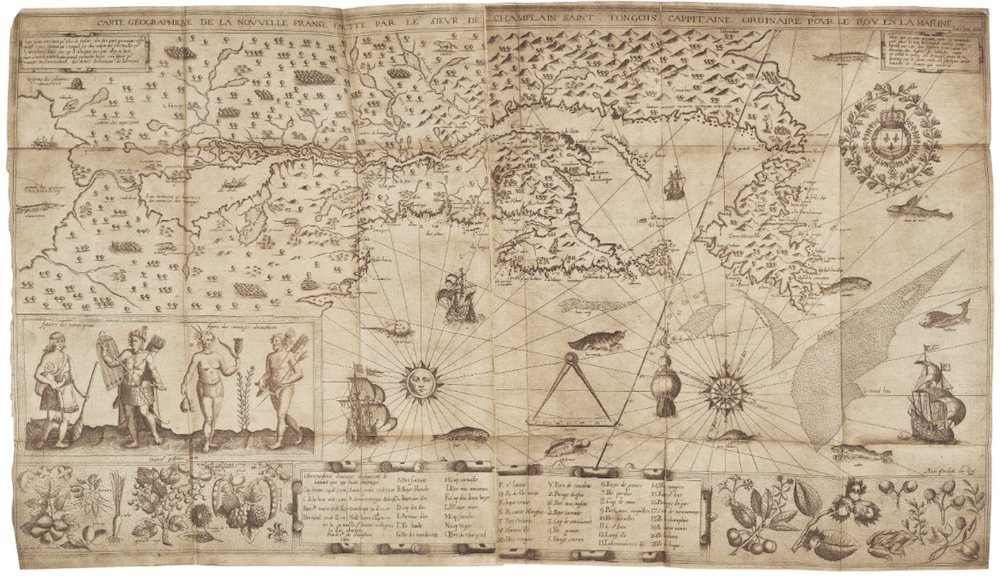

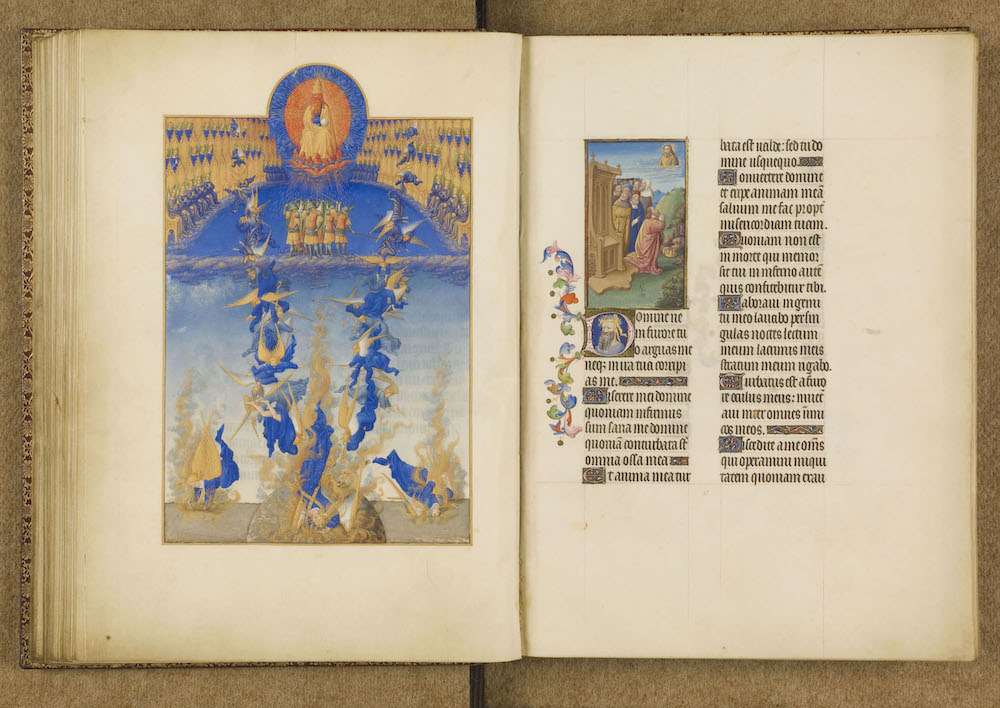

La numérisation patrimoniale de masse dans le domaine du livre exige de revenir aux versions papier des ouvrages.

Il est alors facile de comprendre que le niveau final de qualité de la reconnaissance de caractères dépendra aussi de la qualité des ouvrages qui seront numérisés (qualité du papier, qualité de l'encre, qualité de la formation des caractères, lisibilité de la typo utilisée…).

La numérisation se fera avec deux formats cibles : l'EPUB et le PDF (pour les documents dont la mise en page est complexe ou dont la qualité typographique se révélera très mauvaise).

Dans les deux cas, la SDP appliquera des niveaux de qualité pour la reconnaissance de caractères (OCR) qui sont ceux utilisés par les professionnels de cette industrie.

Pour la numérisation au format ePub, le niveau de qualité garanti par le prestataire de numérisation sera, a minima, de 99,99%.

On comprend ainsi que 99,99 % est un taux minimum admis, soit 1 caractère erroné maximum tous les 10 000 caractères. Et ce sera normalement moins... sans compter qu'en cas de taux d'erreurs plus élevé, la solution du PDF sera préférée.

Le format PDF, de son côté, est un mode image qui reproduit fidèlement la page du livre papier.

La couche texte cachée qui accompagnera ces fichiers PDF sera proposée avec un niveau de qualité de 98,50%, qui permet d'effectuer des recherches.

On descendait donc d'un cran, en perdant 0,009 % de qualité éditoriale, mais les prétentions restaient faramineuses. Surtout qu'Alain Absire, président de la Sofia, à l'occasion de cette réunion, avait bien précisé : « Il n'y a pas de relecture, puisqu'il n'y a pas d'épreuves. » En effet, pour la numérisation des ouvrages, et suite à l'OCR, « la relecture humaine a un coût, qui aujourd'hui n'est pas prévu » dans le cadre de ReLIRE.

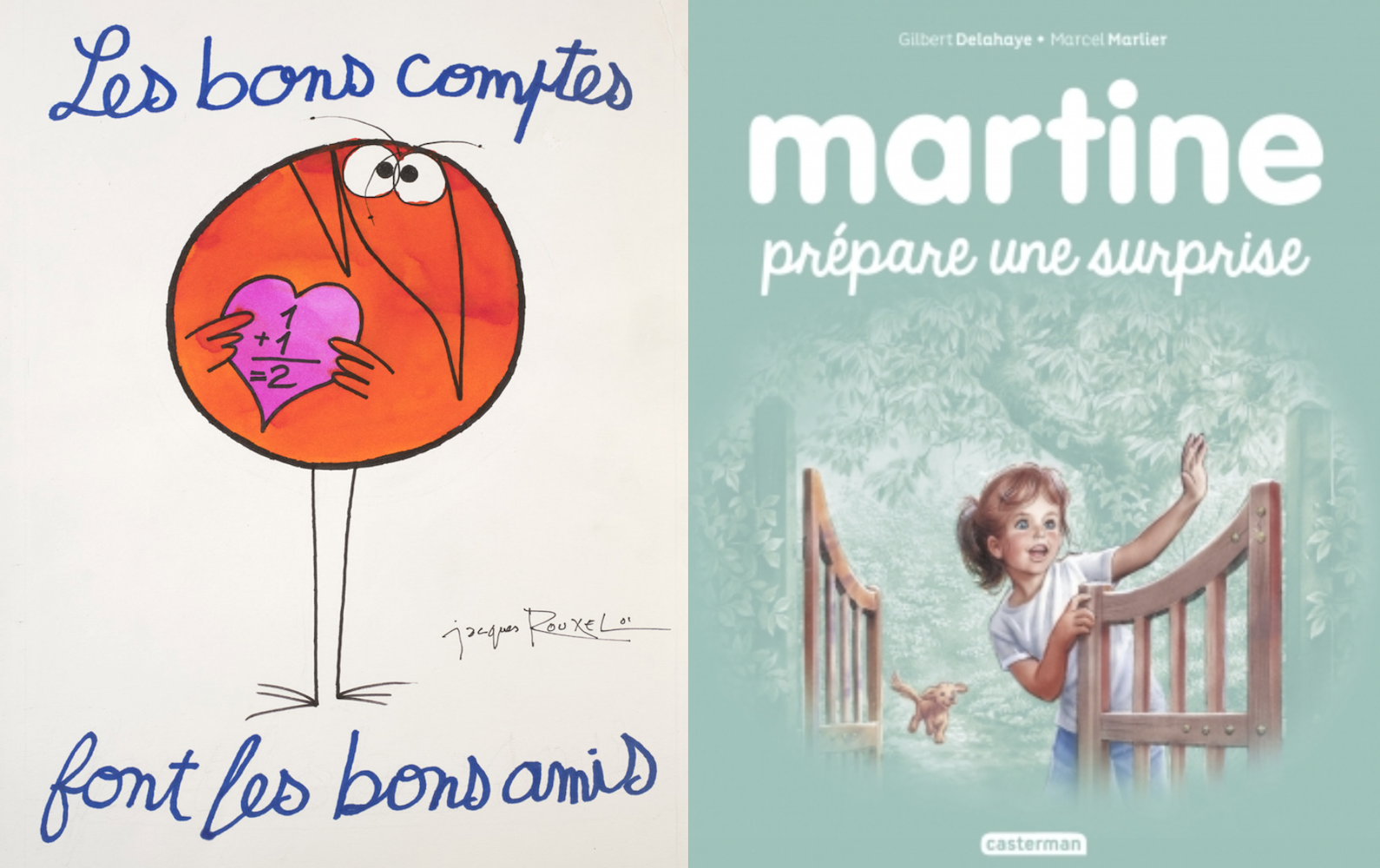

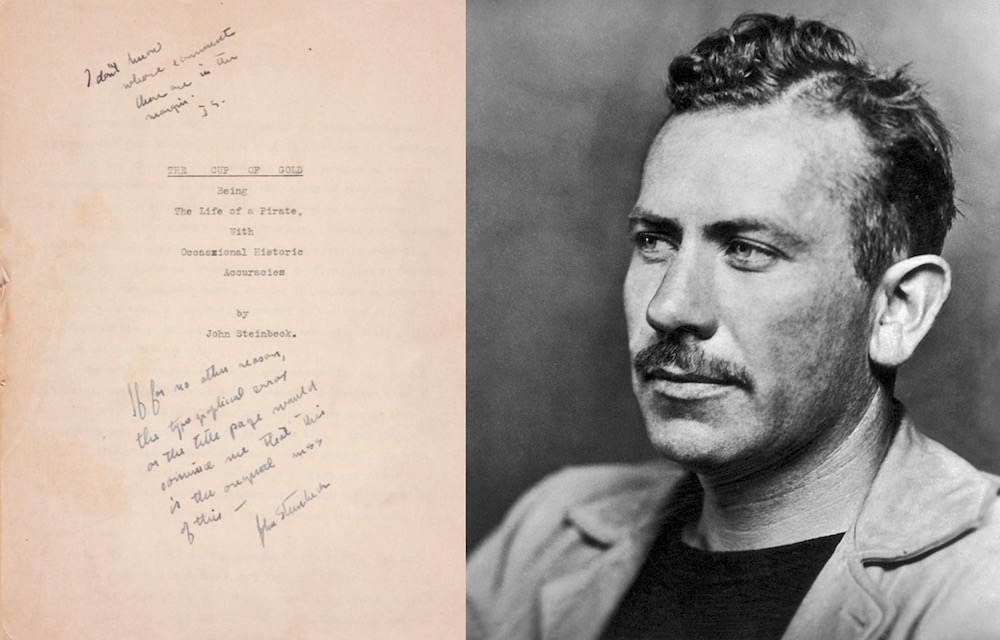

De quoi sérieusement interroger le respect du droit moral. « Une erreur par page, sur un livre numérisé qui a déjà été édité, et qui a donc déjà été corrigé a priori (au XXe siècle, il y avait encore des correcteurs chez les éditeurs) ! Donc en fait, leur numérisation ne va pas laisser un mot erroné par page, mais va ajouter un mot erroné par page depuis un livre qui n'en contenait pas a priori », notait un éditeur numérique.

"99,99 % de qualité éditoriale ne sera jamais atteint"

Pour en avoir le coeur net, nous avons sollicité un spécialiste de la numérisation d'oeuvres, qui se réjouit « que la Sofia adopte une magnifique promesse de qualité dans la numérisation. Certains prestataires garantissent en effet un pareil résultat… mais sans pour autant le livrer au client. En réalité, 99,99 % de qualité éditoriale ne sera jamais atteint ».

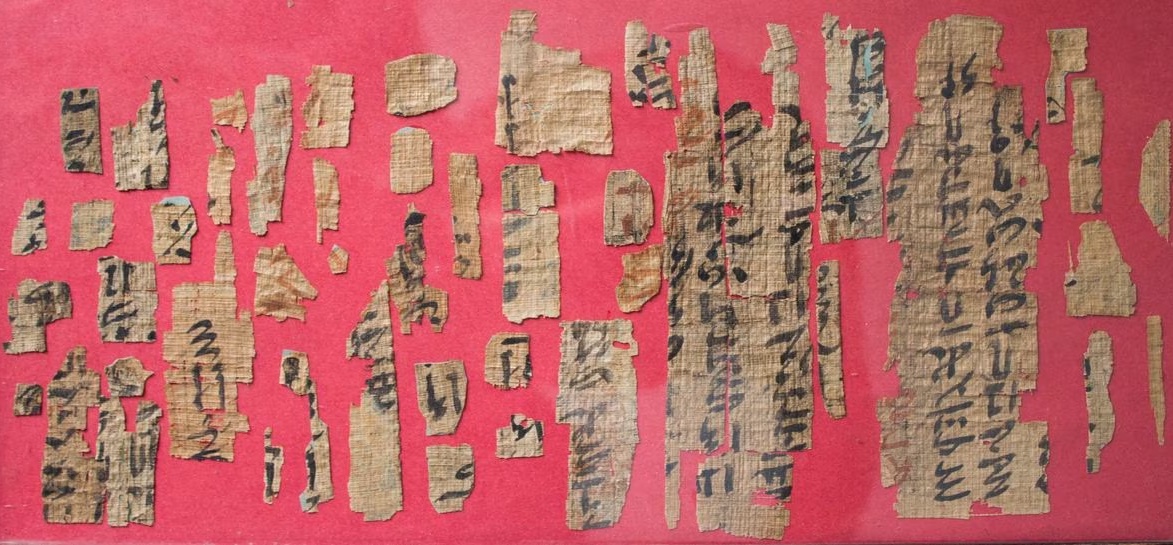

En effet, la Sofia prend bien soin de préciser qu'en fonction de la qualité des ouvrages, on optera pour le format EPUB ou PDF. Or, la numérisation s'effectuera bien à partir des livres présents au dépôt légal de la BnF, des livres qui auront pour certains plusieurs dizaines d'années, dont le papier aura vieilli, l'encre aura pu s'estomper, même partiellement et surtout, qui n'ont pas été religieusement stockés dans des conditions optimums de conservation. En somme, rien à voir avec la numérisation d'un livre de poche sorti la semaine passée en librairie…

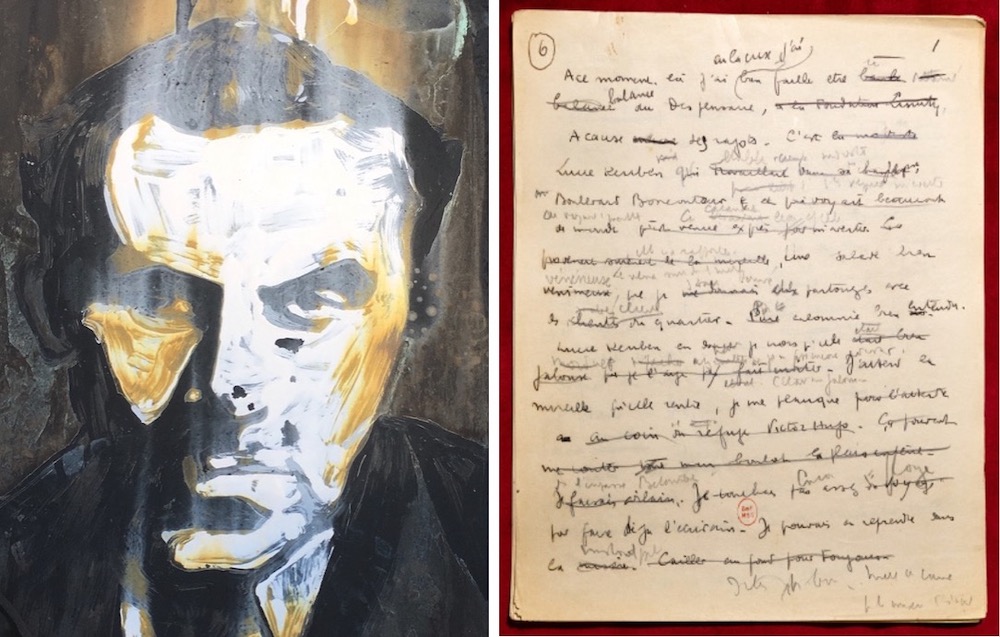

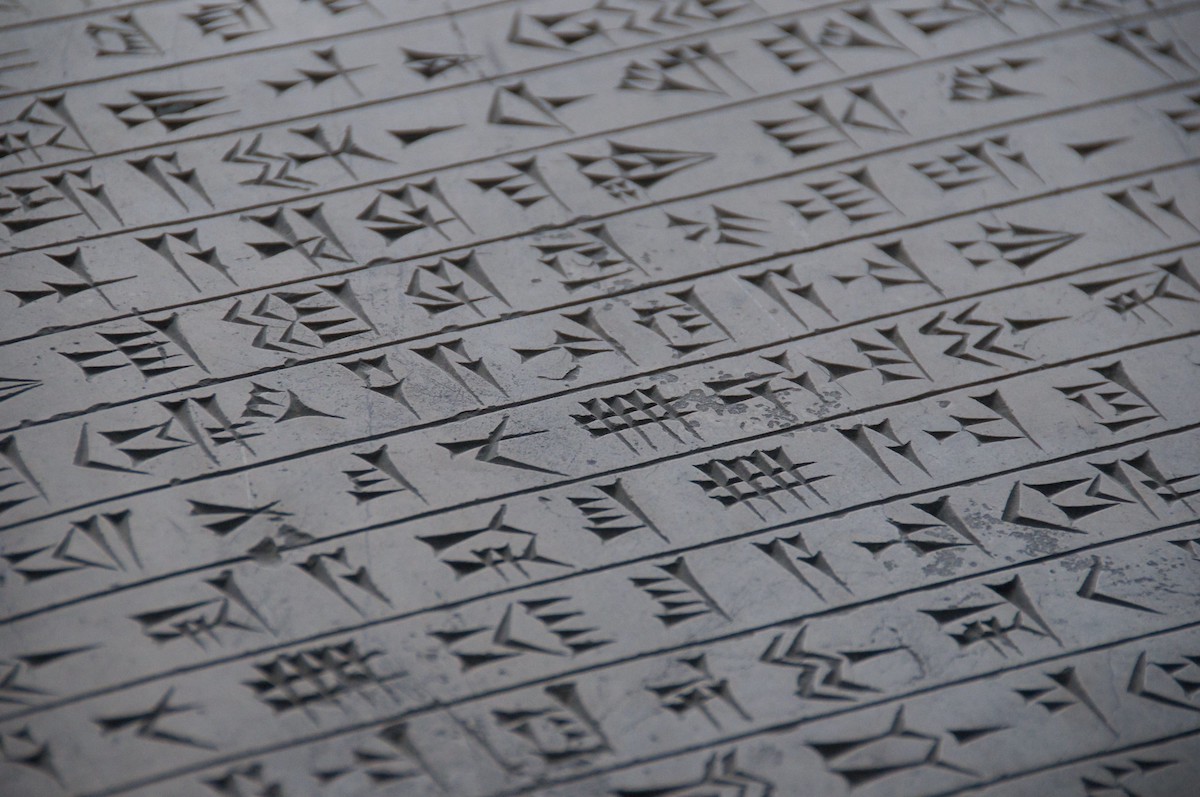

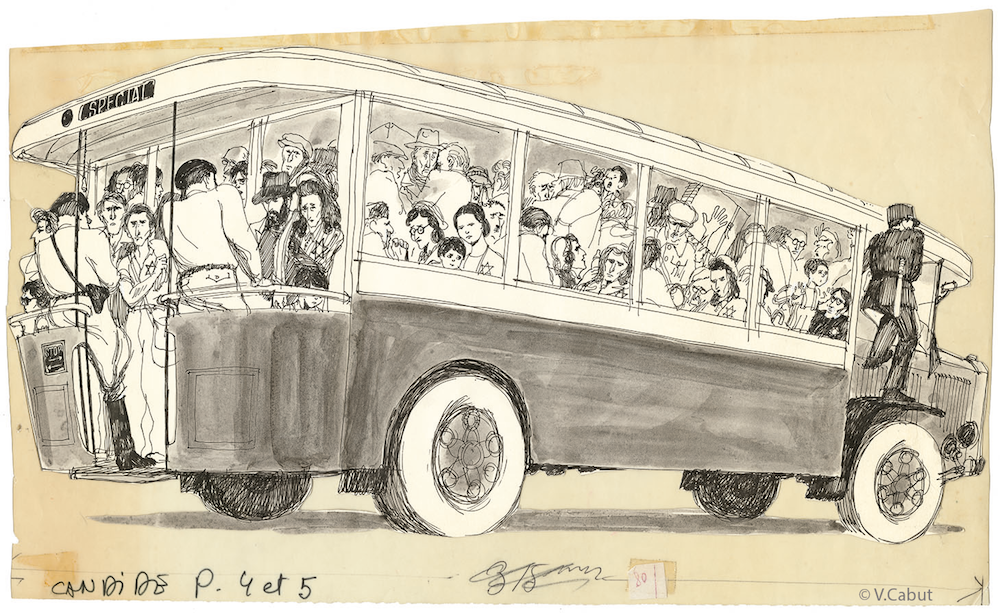

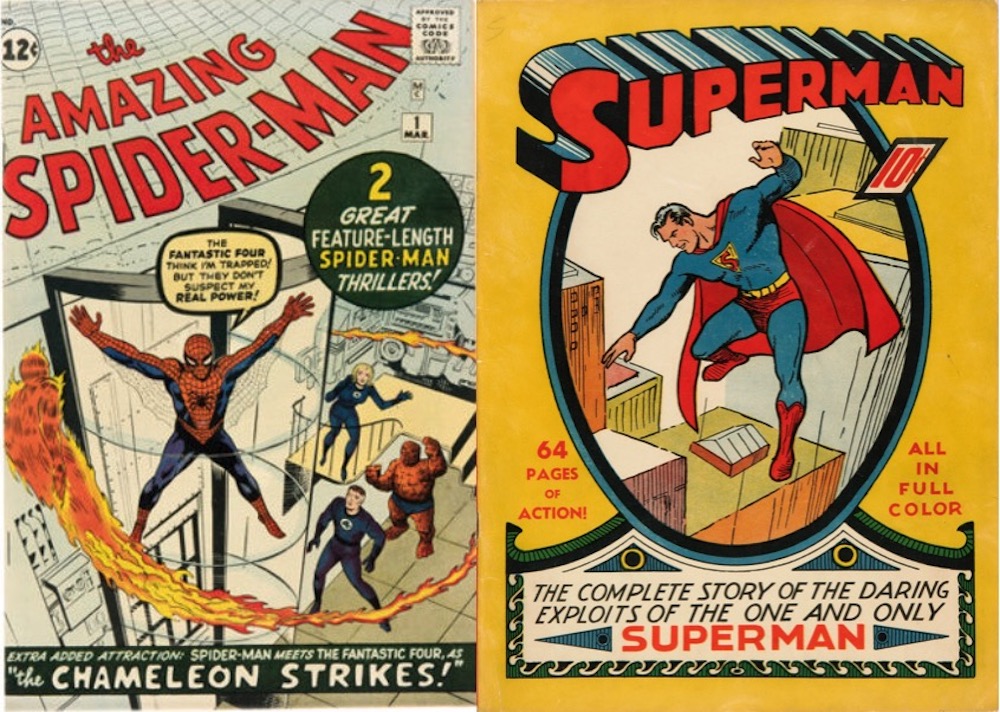

Erreurs de numérisation Google Books

Tu veux mon doigt, la suite...

Il existe aujourd'hui des solutions technologiques permettant, avec des solutions automatisées entièrement, de parvenir à réduire les erreurs des OCR : on va alors pratiquer sur un ouvrage plusieurs reconnaissances de caractères, en s'appuyant sur le fait que toutes les numérisations contiennent des erreurs, mais toutes ne contiennent pas les mêmes. Avec un modèle de recoupement, il sera alors possible d'éliminer plus d'erreurs encore.

Selon nos informations, si l'on peut parvenir avec un OCR simple à du 99 % de qualité, et frôler les 99,9 % avec un système de double, voire triple recoupement, le chiffre de 99,99 % est simplement surréaliste. « Le triple OCR peut parvenir à une qualité de 99,99 %, mais cela se fera avec un ouvrage uniquement, choisi et pour lequel différentes optimisations dans le traitement du texte ont été mises en place. Un tel rendu est impensable avec un spectre large de livres, parce que les optimisations nécessitent de cerner un ouvrage spécifique », nous précise-t-on.

10.000 titres sous les scanners par semaine ? La blague...

Alors, quand on apprend que ce sont 10.000 livres qui devraient être numérisés chaque semaine, pour parvenir au ratio des 500.000 annuels, on sourit. D'autant plus que, pour atteindre les 99,99 %, une fois encore, il faut prendre en compte un coût réel, supérieur à la numérisation simple.

À ce jour, on sait que 230.000 oeuvres seront numérisées, et que le montant de l'opération est chiffré à 30 millions €. Difficile de savoir si le temps et l'attention nécessaire, de même que les optimisations propres à chaque ouvrage, pour atteindre les 99,99 % seront mises en place pour chacun des titres, et surtout, si le montant indiqué couvrirait ces frais. « Personne n'investirait dans une numérisation avec un résultat de 99,99 % pour ces livres », assure un autre spécialiste.

Pour ce qui est de la couche de texte cachée, le taux avancé de 98,50 % est en revanche, tout à fait crédible - et assez largement pratiqué. « C'est une qualité admise comme suffisante, puisqu'il de fichier image que l'on va lire, et que le texte caché n'est là que pour assurer des recherches plein texte. Bien évidemment, si l'on a besoin de faire des copier-coller de passages entiers, cela n'est pas extraordinaire, mais après tout, un avertissement signale bien que le texte est issu d'un processus de numérisation et de reconnaissance de caractères, justement à des fins de recherche », souligne-t-on.

Le piège, en revanche, est que souvent - c'est par exemple le cas pour les livres numérisés de Gallica - le cahier des charges ne prend pas en compte certains éléments : ainsi, la ponctuation ou les chiffres ne font pas partie des caractères comptabilisés pour arriver à 98,50 % de réussite. Et pour cause, plaisante notre interlocuteur, « vous avez souvent fait une recherche sur le nombre de virgules contenues dans un texte » ? Effectivement. Mais derrière la boutade, certains riront jaune.

Reste qu'une nouvelle réunion organisée par la Sofia, et se déroulant ce soir au Centre National du Livre à partir de 18h30 permettra peut-être d'éclaircir ces différents points, et d'expliquer comment la numérisation pratiquée par la Société de Projet permettra d'atteindre des résultats… impossibles. Comme on a l'habitude de répondre dans le monde informatique : «Le possible est déjà fait, l'impossible est en cours, pour les miracles prévoir un délai !»

Google Books OCR Conversion! from brainout on Vimeo.

Commenter cet article