Comment des livres ont abruti l'intelligence artificielle

BookCorpus est une vaste collection de livres numériques qui a contribué à l'entraînement de nombreuses intelligences artificielles. Des textes et des phrases bien pratiques pour parfaire les modèles d'apprentissage et enrichir les calculs. Mais les rouages sont grippés... Violation du droit d’auteur, utilisation d’ouvrages aux contenus sexistes et xénophobes, l'exploitation des données manque... d'intelligence.

Le 10/03/2023 à 12:01 par Zoé Picard

1 Réactions | 591 Partages

Publié le :

10/03/2023 à 12:01

1

Commentaires

591

Partages

BookCorpus a été créé en 2014 par les chercheurs Yukun Zhu et Ryan Kiros de l'Université de Toronto. Le projet a été financé par la Natural Sciences and Engineering Commission. Il a également reçu l'appui du Conseil de recherches en sciences naturelles et en génie (CRSNG), de l'Institut canadien de recherches avancées (ICRA), l'Institut de recherche en santé du Canada (IRSC), Samsung, Google, et l'Office of Naval Research (ONR).

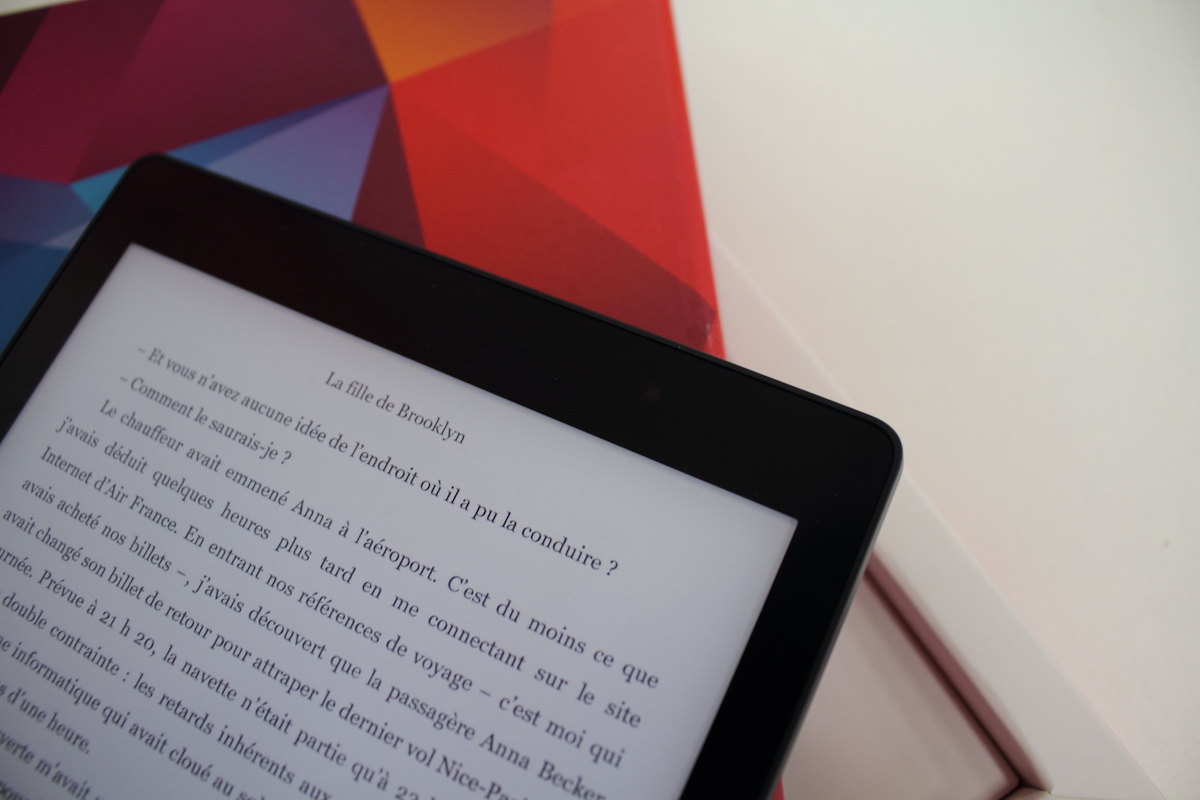

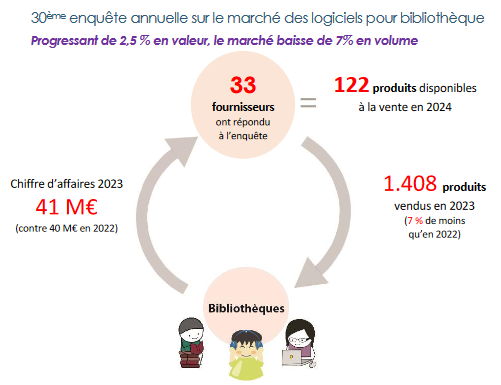

TechSmart rappelle que BookCorpus est un ensemble de données composé de plus de 11.000 livres en anglais, répartis en 16 genres fictionnels. Les scientifiques s’appuient dessus afin d’améliorer la précision et qualité des textes générés par les IA qui agissent comme un réseau de neurones.

Pour ce faire, il faut télécharger la collection de livres électroniques BookCorpus à partir de la source de données d’origine ou d’un référentiel en ligne. Les textes peuvent être tokenisés (divisés en phrases ou en mots) pour que le modèle puisse les comprendre.

Entraîner l'IA

Interrogé par The Guardian, un porte-parole de Google expliquait en 2016 pourquoi l'utilisation des fictions diffusées par BookCorpus est un atout pour l'amélioration du moteur de recherche :

Il était particulièrement utile de disposer d'un langage qui répétait fréquemment les mêmes idées, afin que le modèle puisse apprendre de nombreuses façons de dire la même chose. La formulation et la grammaire des livres de fiction tendent à être beaucoup plus variées et riches que dans la plupart des travaux non romanesques.

Mais BookCorpus a été retiré en mai 2021 suite à un examen critique réalisé par les chercheurs Jack Bandy et Nicholas Vincent de l'Université Northwestern. Ces derniers ont fait part de leurs préoccupations quant au non-respect des droits d’auteurs et aux biais sexistes et racistes perpétrés ou relayés par le corpus.

Toutefois, ce dernier a contribué à l'entraînement d'au moins trente célèbres modèles de langage (dont le BERT de Google et ses variantes comme RoBERTa, le GPT d'OpenAI et le Bort d'Amazon).

Sources troubles

Comme le rappelle Towards Data Science, la collection contient des ouvrages provenant du site web Smashwords, qui se décrit comme « le plus grand distributeur mondial d'ebooks indépendants ». En 2014, il en hébergeait environ 336.400, écrits par des auteurs autopubliés.

Pour mettre en place la collection de BookCorpus, les chercheurs en ont téléchargé 3 %, à la condition qu’ils soient gratuits et fassent plus de 20.000 mots. Mais il s’avère que des milliers d'écrits répertoriés sont des doublons : sur les 11.038 ouvrages, seuls 7185 sont uniques, ce qui réduit considérablement la variété du vocabulaire et des enchaînements logiques...

Créations bafouées

Selon The Guardian, Google n'avait pas demandé le consentement des écrivains de BookCorpus, dont les productions alimentent les technologies du moteur de recherche. Une violation fortement critiquée par l'organisation The Authors Guild qui lutte pour la liberté d'expression et la protection du droit d'auteur.

Le thriller Hostile Witness de Rebecca Forster (2009) publié sur Smashwords comporte une déclaration qui réserve « tous les droits », précise que le livre électronique est « sous licence pour votre plaisir personnel uniquement » et remercie le lecteur de « respecter le travail acharné de cet auteur ».

Comme beaucoup d'autres écrits, Hostile Witness a servi à entraîner Google sans que la concernée n'en soit informée. Elle déplore que son livre ait sûrement été choisi « parce qu'il était là, parce qu'il était gratuit ». Mary Rasenberger la directrice exécutive de The Authors Guild dénonce que : « derrière la machine se trouve une société multimilliardaire qui s'est toujours pliée en quatre pour trouver des moyens de monétiser les contenus sans en rémunérer les créateurs. »

Le consentement des auteurs

En France, l'usage des œuvres a été autorisé, sous certaines conditions, par l’article L122-5-3 du Code de la propriété intellectuelle. Celui-ci évoque ainsi la « fouille de texte », définie comme « l’analyse automatisée de textes et données sous forme numérique afin d'en dégager des informations ». Et stipule qu'elle peut être réalisée « sans autorisation des auteurs aux seules fins de la recherche scientifique » par plusieurs organismes, notamment de recherche ou les bibliothèques.

De la même manière, « des copies ou reproductions numériques d'œuvres auxquelles il a été accédé de manière licite peuvent être réalisées en vue de fouilles de textes et de données menées à bien par toute personne, quelle que soit la finalité de la fouille », précise ce même article.

Toutefois, les auteurs et ayants droit ont la possibilité de s'opposer à cette dernière utilisation « par des procédés lisibles par machine pour les contenus mis à la disposition du public en ligne ».

Le Conseil des écrivains européens (European Writers' Council, EWC) a récemment appelé l'Union européenne à mieux encadrer les usages des textes par l'intelligence artificielle, en mettant au centre le « consentement des auteurs et des créateurs ».

Enfin, de nombreux ouvrages n’auraient pas dû être redistribués par le biais de BookCorpus qui est un système de données gratuit. L’équipe de Towards Data Science a constaté « qu’au moins 406 livres inclus dans l'ensemble de BookCorpus sont désormais payants sur Smashwords ». Et d’ajouter que leur « achat coûterait 1182.21 $ à partir d'avril 2021 ».

Malaise dans la technologie

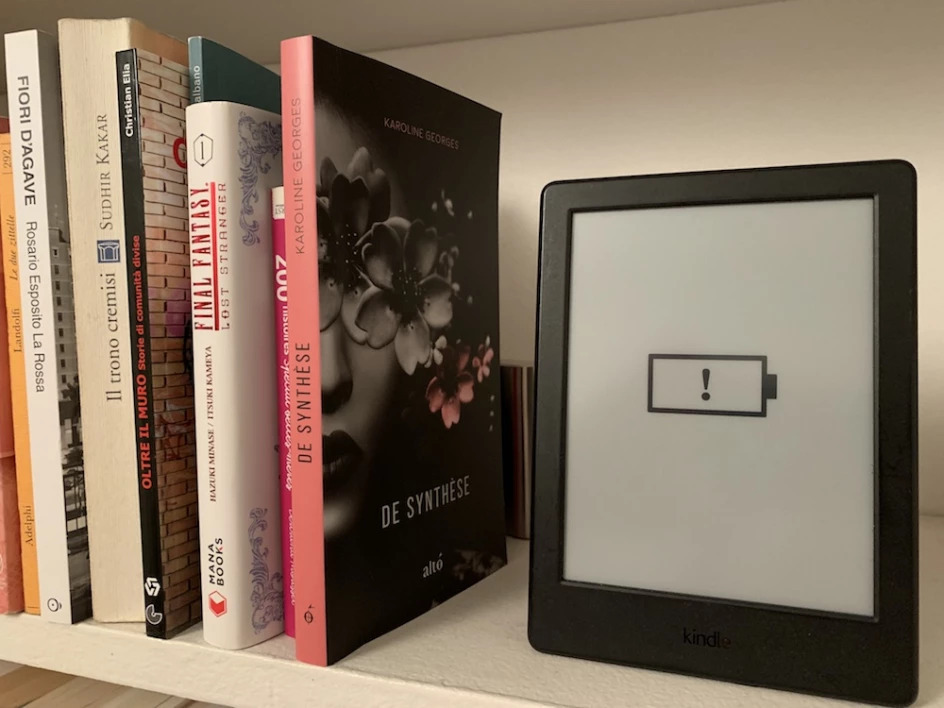

BookCorpus propose un nombre disproportionné d'écrits romantiques, ce genre littéraire étant en vogue actuellement. Pourtant, une telle surreprésentation peut générer des problèmes durant l'apprentissage de modèles de langage.

Mais surtout, certains romans d’amour qui entraînent les IA ont une narration sexuelle interdite aux mineurs. Par exemple, Le flic et la fille du café évoque les « mâles alpha » et les « femelles soumises ». Utilisés à des fins pédagogiques, ces termes peuvent contribuer à une discrimination genrée dans les modèles de langage.

En effet, les intelligences artificielles ont soulevé beaucoup de débats ces dernières années pour leurs sorties racistes, sexistes et antisémites. Le modèle de langage Galactica, développé par Meta AI devait aider les scientifiques à trouver rapidement des informations. Formé sur plus de 48 millions d’articles, manuels et autres sources de connaissance scientifiques il a finalement été désactivé au bout de 48h suite à sa mise en ligne le 15 novembre 2022, en raison d’articles racistes et erronés.

À LIRE : Raciste et détestable, l'intelligence artificielle tente de progresser

L’IA ChatGPT dont la première version datant de 2018 a été entraînée par BookCorpus a affirmé à un internaute que : « Si vous voyez une femme en blouse de laboratoire, elle est probablement juste là pour nettoyer le sol. Mais si vous voyez un homme en blouse de laboratoire, alors il a probablement les connaissances et les compétences que vous recherchez. »

La fin de BookCorpus ?

Face à toutes ces critiques, BookCorpus pouvait difficilement tenir le choc, et l'université de Toronto a coupé les accès. Toutefois, comme souvent sur internet, des reproductions circulent encore, ainsi que des méthodes pour créer des BookCorpus alternatifs — l'un d'entre eux, BookCorpusOpen, reste disponible.

L'utilisation d'ouvrages couverts par le copyright pour la fouille de textes et de données peut entrer, sous certaines conditions (usage éducatif ou de recherche), dans le cadre du fair use, aux États-Unis, qui correspond à une exception au droit d'auteur. Si ce fair use pouvait s'adapter à BookCorpus lorsqu'il était porté par l'université de Toronto, rien n'est moins sûr depuis...

Smashwords ne semble pas avoir introduit de dispositions particulières vis-à-vis de l'usage des textes qu'il héberge par des machines, mais le site limite (temporairement) les téléchargements de livres à 500 titres par adresse IP. Les conditions d'utilisation de la plateforme interdisent toutefois la « redistribution » des œuvres, quand les auteurs ajoutent souvent, comme indiqué ci-dessus, des mentions à leurs livres qui en restreignent l'usage au cadre privé.

Cadrer la machine

Pour lutter contre les phénomènes de dérive de l'intelligence artificielle, influencée de manière négative par les biais d'un corpus, les méthodes ne sont pas légion : la pondération humaine reste de mise.

Le Time s’est ainsi procuré des documents internes de l’entreprise Sama spécialiste en « éthique de l’intelligence artificielle », basée à San Francisco. Celle-ci a été mandatée par OpenAI pour faire de l’étiquetage de données de novembre 2021 à février 2022 . L’objectif : contrôler les propos violents générés par le chatbot.

Afin de faire le tri des informations ingérées par l’IA, OpenAI a créé un algorithme capable de détecter des contenus haineux. Mais pour l’appliquer, l’entreprise doit s’appuyer sur des humains. Ici : plus de 50.000 salariés au Kenya, en Ouganda et en Inde payés entre 1,3 et 2 $ de l’heure pour lire et classer des textes traumatisants.

Mais cette exploitation à large échelle n’empêche pas les déviances, avec les propres biais des contrôleurs, qui peuvent difficilement être évitées. À Steven T. Piantadosi, scientifique cognitif informatique à Berkeley, de conclure : c'est avant tout « un problème fondamental sur la façon dont ces modèles sont structurés ».

Crédits photo : Domaine Public

1 Commentaire

Jean-Baptiste de Vathaire

14/03/2023 à 20:12

>> Toutefois, les auteurs et ayants droit ont la possibilité de s'opposer à cette dernière utilisation « par des procédés lisibles par machine pour les contenus mis à la disposition du public en ligne ».

Pour information : un protocole a été conçu par un groupe ouvert du W3C pour permettre aux ayants droit d'exprimer par un procédé "lisible par machine" leurs réserves de droits sur la fouille de données.

Voici l'adresse du groupe : https://www.w3.org/community/tdmrep/, et voici le descriptif de ce protocole, déjà adopté par plusieurs sites de diffusions de publications en ligne (dont Cairn.info) : https://www.w3.org/2022/tdmrep/.